ENTROPIE

V ↗kvantitativní lingvistice se používá při analýzách textu a označuje stupeň diverzifikovanosti sledovaných jednotek (syntagmat, slovních tvarů, lemmat, morfů, slabik, fonémů, hlásek atp.). Čím je e. vyšší, tím je vyrovnanější poměr daných jednotek v textu, nízká e. je naopak projevem vysoké koncentrace, kdy několik málo jednotek se vyskytuje s výrazně vyšší frekvencí.

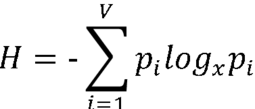

Do lingvistiky byl pojem e. zaveden z teorie informace. Přestože existuje množství různých definic e. (srov. ✍Esteban & Morales, 1995), v lingvistice se zpravidla používá pojetí ✍Shanonna (1948), který ji definoval jako

,

,

kde pi je pravděpodobnost dané jednotky v textu, logx je logaritmus o základu x (zpravidla se používá binární logaritmus o základu x = 2 n. přirozený logaritmus o základu x = e, kde e ≈ 2,718 je Eulerovo číslo) a V je počet různých jednotek (typů). Pravděpodobnost pi se odhaduje prostřednictvím relativní frekvence, tj.

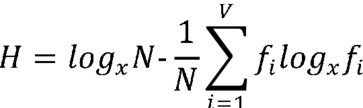

,

,

kde fi je frekvence jednotky v textu a N počet všech jednotek (tokenů). Původní vzorec lze tak zapsat jako

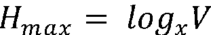

Minimální míra entropie Hmin = 0 by nastala v případě, že by text byl tvořen jedinou jednotkou, která by se neustále opakovala. Naopak maximální entropii by měl text, ve kterém by se všechny jednotky vyskytovaly se stejnou frekvencí:

Míra e. textu se pohybuje v intervalu <0, logxV>, její hodnotu tedy významně ovlivňuje počet různých jednotek (typů) v textu. V případě analýzy entropie založené na frekvenci jednotek s velkým inventářem, jako jsou slovní tvary, lemmata, slabiky či morfy, je počet různých jednotek v textu závislý na jeho délce, tudíž je na délce textu závislá i hodnota maximální entropie Hmax (k vlivu délky textu viz ↗slovní bohatství textu). To znamená, že je neadekvátní porovnávat texty o různé délce a je nutné buď

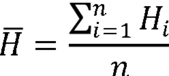

(a) text segmentovat na stejné délkové úseky (např. 100 jednotek), v každému úseku zjistit entropii a následně vypočítat průměrnou hodnotu entropie  , tj.

, tj.

,

,

kde Hi je entropie daného úseku a n je počet těchto úseků v textu, n.

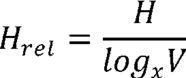

(b) pracovat s relativní hodnotu entropie Hrel, která je definována jako poměr empirické entropie H vzhledem k jejímu maximu, tj.

V případě analýzy e. založené na frekvenci jednotek s relativně malým inventářem – v jazyce jde zřejmě jen o hlásky či fonémy (je však možné pracovat také s kategoriemi, jako je gramatický pád, slovní druh, sémantická role, větný člen atp.) – dojde v textu (pokud je dostatečně dlouhý) ke stavu, kdy se v něm realizuje celý inventář sledovaných jednotek. Od toho stavu již délka textu nehraje roli, a je proto možné porovnávat texty různé délky.

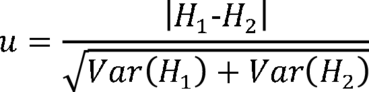

Rozdíly mezi hodnotami entropie H lze v dostatečně dlouhých textech statisticky testovat prostřednictvím asymptotického testu

,

,

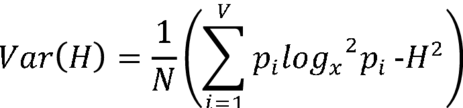

kde H1 a H2 jsou entropie dvou různých textů a Var(H) je rozptyl, jenž ✍Popescu & Vidya ad. (2009:184) ho definují

E. slovních tvarů či lemmat v textu je možné interpretovat ve vztahu k ↗slovnímu bohatství textu, e. hlásek ve verši ve vztahu k eufonii, e. slabik k průměrné délce slova v jazyce, e. fonémů k míře jejich redundance ve slovech atd. E. se také používá v numerické estetice (✍Bartók & Janoušek, 1980; ✍Birkhoff, 1933; ✍Moles, 1968; ✍Rigau & Feixas ad., 2007). Obecně lze říct, že e. je jedním ze způsobů, jak charakterizovat distribuci zvolených jednotek v textu či jazyce.

- Bartók, I. & I. Janoušek. Počítače a umenie, 1980.

- Benešová, M. Poe’s Raven and the Theory of Information. Czech and Slovak Linguistic Review, 2012, 28–61.

- Birkhoff, G. D. Aesthetic Measure, 1933.

- Buiatti, M. & P. Grigolini ad. A Non Extensive Approach to the Entropy of Symbolic Sequences. Physica A 268, 1999, 214–228.

- Cover, T. M. & J. A. Thomas. Elements of Information Theory, 2006.

- Esteban, M. D. & D. Morales. A Summary of Entropy Statistics. Kybernetika 31, 1995, 337–346.

- Herdan, G. The Advanced Theories of Language as Choice and Chance, 1966.

- Moles, A. Information Theory and Esthetic Perception, 1968.

- Popescu, I.-I. & M. N. Vidya ad. Word Frequency Studies, 2009.

- Rigau, J. & M. Feixas ad. Conceptualizing Birkhoff’s Aesthetic Measure Using Shannon Entropy and Kolmogorov Complexity. In Cunningham, D. W. & G. W. Meyer ad. (eds.), Proceedings of Computational Aesthetics, 2007, 105–112.

- Shannon, C. The Mathematical Theory of Communication. Bell System Technical Journal 27, 1948, 379–423.

URL: https://www.czechency.org/slovnik/ENTROPIE (poslední přístup: 23. 4. 2024)

Další pojmy:

kvantitativní lingvistikaCzechEncy – Nový encyklopedický slovník češtiny

Všechna práva vyhrazena © Masarykova univerzita, Brno 2012–2020

Provozuje Centrum zpracování přirozeného jazyka